一、引言

一、引言

在信息爆炸的时代,如何从海量数据中快速获取有价值的信息成为了一个重要课题。爬虫技术作为一种自动化数据抓取工具,在各个领域都发挥着重要作用。本文将聚焦于爬虫技术在微信公众号文章爬取中的应用,为读者提供一份详尽的指南。

二、爬虫技术基础

爬虫技术,又称网络爬虫或网络蜘蛛,是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。它通常用于搜索引擎、数据挖掘、信息监测等领域。爬虫的基本工作流程包括发送请求、接收响应、解析网页、提取数据、存储数据等步骤。

三、微信公众号文章爬取挑战

微信公众号作为当前最热门的社交媒体平台之一,拥有庞大的用户群体和丰富的内容资源。然而,爬取微信公众号文章却面临着诸多挑战。一方面,微信公众号平台对爬虫行为进行了严格的限制,设置了反爬虫机制;另一方面,微信公众号文章的页面结构复杂多变,增加了爬取的难度。

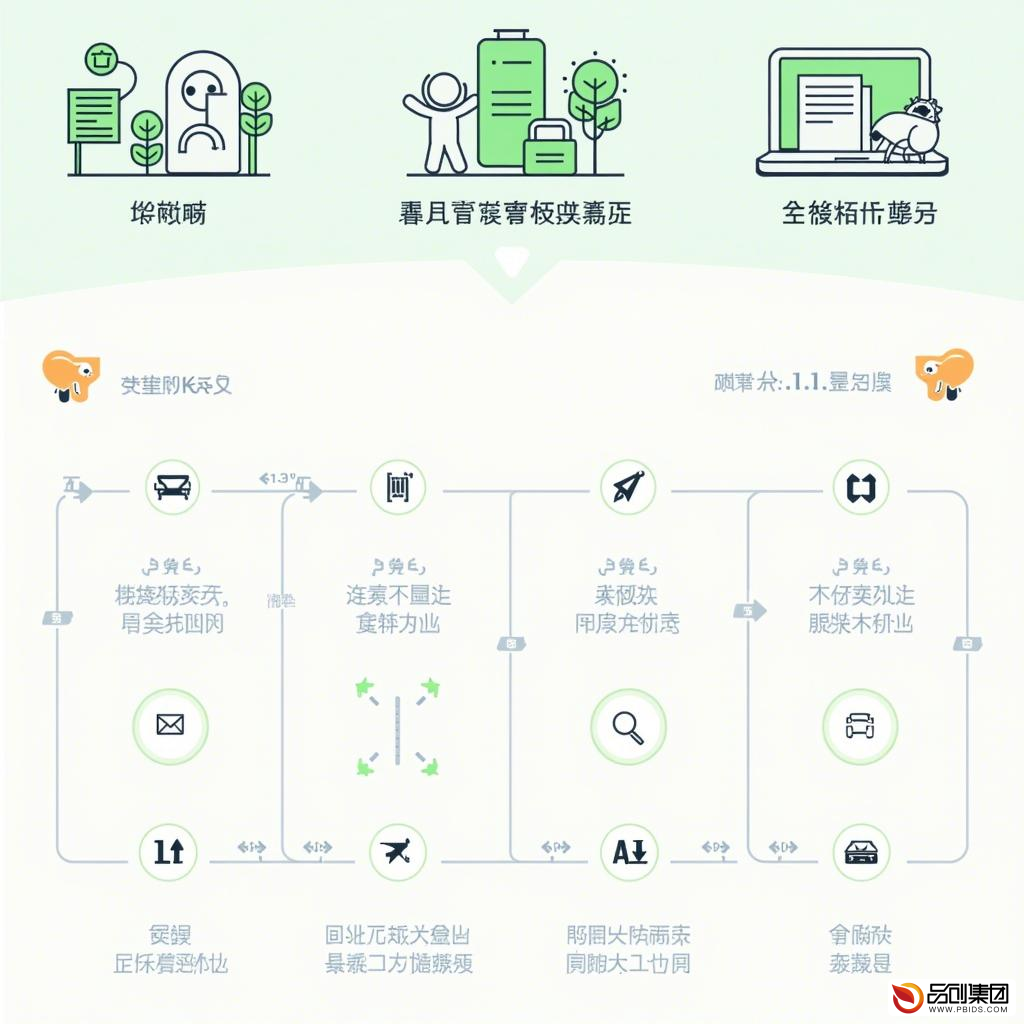

四、高效爬取微信公众号文章的策略

-

分析目标网站结构:在爬取之前,需要对目标网站(即微信公众号平台)进行结构分析,了解文章的页面布局、数据接口等信息。

-

模拟用户行为:为了避免触发反爬虫机制,爬虫需要模拟真实用户的浏览行为,如设置合理的请求间隔、使用代理IP等。

-

使用合适的解析工具:根据目标网站的页面结构,选择合适的解析工具(如BeautifulSoup、lxml等)来提取所需数据。

-

数据清洗与存储:对提取到的数据进行清洗和整理,去除无用信息,并存储到合适的数据结构中(如数据库、Excel等)。

五、实战案例:爬取某微信公众号文章

以下是一个使用Python编写的爬虫程序示例,用于爬取某微信公众号的一篇文章。该程序使用了requests库发送HTTP请求,BeautifulSoup库解析网页内容,以及pandas库存储数据。

(注:由于微信公众号平台的反爬虫机制较为严格,以下示例仅用于教学目的,请勿用于非法用途。)

import requests

from bs4 import BeautifulSoup

import pandas as pd

# 目标微信公众号文章的URL(需替换为实际文章的URL)

url = 'https://mp.weixin.qq.com/s/xxxxxx'

# 发送HTTP请求获取网页内容

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.71 Safari/537.36'

}

response = requests.get(url, headers=headers)

response.encoding = 'utf-8'

html_content = response.text

# 解析网页内容提取文章信息

soup = BeautifulSoup(html_content, 'html.parser')

article_title = soup.find('h2', class_='rich_media_title').get_text()

article_content = ''

for p in soup.find_all('p'):

article_content += p.get_text() + '\n'

# 存储数据到DataFrame中

data = {

'标题': [article_title],

'内容': [article_content]

}

df = pd.DataFrame(data)

# 将DataFrame保存为Excel文件

df.to_excel('微信公众号文章.xlsx', index=False)

六、合法性与伦理考量

在爬取微信公众号文章时,必须严格遵守相关法律法规和平台规定。未经授权擅自爬取他人文章属于侵权行为,可能会面临法律责任。因此,在进行爬虫操作前,务必了解并遵守相关法律法规和平台规定。

七、结论与展望

随着大数据时代的到来,爬虫技术在信息获取领域的应用将越来越广泛。对于微信公众号文章的爬取而言,虽然面临着诸多挑战,但通过合理的策略和工具选择,仍然可以实现高效、合法的数据抓取。未来,随着技术的不断进步和法律法规的完善,爬虫技术将在更多领域发挥重要作用。